+- | NuclearMeeting | il forum di ArchivioNucleare.com | (http://www.nuclearmeeting.com/forum)

+-- Forum: Argomenti (/forumdisplay.php?fid=1)

+--- Forum: Nucleare e Radioprotezione (/forumdisplay.php?fid=2)

+--- Discussione: [OT] Scienza e Tecnologia (/showthread.php?tid=327)

[OT] Scienza e Tecnologia - magnesium - 26-09-2011 20:46

Si apre questa discussione con l' intenzione di creare un luogo all' interno del quale gli utenti possono discutere di tutti quegli argomenti legati al mondo della "scienza e tecnologia" ma NON strettamente attinenti con le tematiche principali del forum e che quindi altrimenti non avrebbero un luogo adatto per essere affrontati.

[OT = Off topic = Fuori tema]

RE: [OT] Scienza e Tecnologia - mi.greco - 28-09-2011 15:29

Mi auguro che l' Editore, I Moderatori e tutti i Membri di Nuclear Meeting vogliano unirsi al mio augurio rivolto alla professoressa Emilia Chiancone nuovo Presidente dell' Accademia delle Scienze detta dei XL eletta al posto del compianto Tommaso Scarascia Mugnozza recentemente scomparso.Ne riporto la biografia essenziale:

Prof. Emilia Chiancone

Department of Biochemical Sciences

University of Rome "La Sapienza" P.le Aldo Moro, 5

00185 Rome

in 2002: present: Director, National Research Council Institute of Molecular Biology and Pathology, University 'La Sapienza' Rome, Italy

in 1989: present: Full Professor of Molecular Biology, Faculty of Medicine, University 'La Sapienza' Rome, Italy

in 1981-2001: Director, National Research Council Center of Molecular Biology, University 'La Sapienza' Rome, Italy

in 1962-1989: Research fellow of the National Research Council Center of Molecular Biology, University 'La Sapienza' Rome, Italy

in 1967: "Libera Docenza" in Biological Chemistry

in 1961: Degree in Biology (with honors), University of Milan, Italy

Memberships and honours

Società di Biofisica e Biologia Molecolare (President of the Society from 1989 to 1992) Accademia Nazionale delle Scienze detta dei XL since 1998

EMBO member since 1980,

ASBMB member since 2002

Areas of research

Studies on heme proteins with special emphasis on the relationship between state of aggregation and functional properties.

Characterization of protein-protein interactions and reversible association-dissociation equilibria by physico-chemical techniques.

Structure-function relationships in mammalian and bacterial ferritins

Structure-function relationships of Ca2+-binding proteins

Development of a chromatographic technique (subunit-exchange-chromatography) involving exchange of protein subunits between a liquid and a solid phase.

Studies of protein-ion interactions (e.g.; Cl-, Na+ and Ca2+).

List of recent publications

M. Mella, G. Colotti, C. Zamparelli, D. Verzili, A. Ilari, and E.Chiancone - Information transfer in the penta-EF-hand protein sorcin does not operate via the canonical structural/functional pairing. A study with site-specific mutants. - J Biol Chem. 278, 24921-24928 (2003).

P. Ceci, A. Ilari, E. Falvo, and E. Chiancone - The Dps protein of Agrobacterium tumefaciens does not bind to DNA but protects it toward oxidative cleavage: X-ray crystal structure, iron binding, and hydroxyl-radical scavenging properties. - J Biol Chem. 278, 20319-20326 (2003)

G. Zhao, P. Ceci, A. Ilari, L. Giangiacomo, T.M. Laue, E. Chiancone, and N.D. Chasteen. - Iron and hydrogen peroxide detoxification properties of DNA-binding protein from starved cells. A ferritin-like DNA-binding protein of Escherichia coli. J Biol Chem. 277, 27689-27696 (2002).

A. Boffi, P. Sarti, G. Amiconi, and E. Chiancone - The interplay between heme iron and protein sulfhydryls in the reaction of dimeric Scapharca inaequivalvis hemoglobin wit nitric oxide, Biophys. Chem., 98, 209-216 (2002).

A. Ilari, K.A. Johnson, V. Nastopoulos, D. Verzili, C. Zamparelli, G. Colotti, D. Tsernoglou and E. Chiancone - The crystal structure of the sorcin calcium domain provides a model of Ca2+-dependent processes in the full-length protein - J. Mol. Biol., 317, 447-458 (2002).

P. Ceci, L. Giangiacomo, A. Boffi, and E. Chiancone – The mutation K30D disrupts the only salt bridge at the subunit interface of the homodimeric hemoglobin from Scapharca inaequivalvis and changes the mechanism of cooperativity - J. Biol. Chem., 277, 6929-6933 (2002).

171) G. Mignogna, R. Chiaraluce, V. Consalvi, S. Cavallo, S. Stefanini, E. Chiancone -Ferritin from the spleen of the Antarctic teleost Trematomus bernacchii is an M-type homopolymer. Eur. J. Biochem. 269, 1600-1606 (2002).

A. Fago, L. Giangiacomo, R. D’Avino, V. Carratore, M. Romano, A. Boffi, and E. Chiancone - Hagfish hemoglobins. Structure, function and oxygen-linked association - J. Biol. Chem, 276, 27415-27423 (2001).

A. Nastopoulos, A. Ilari, G. Colotti, C. Zamparelli, D. Verzili, E. Chiancone, and D. Tsernoglou - Two different crystal forms of sorcin, a penta-EF hand Ca2+-binding protein -Acta Cryst. D57, 862-864 (2001).

L. Giangiacomo, R. D’Avino, G. di Prisco, and E. Chiancone - Hemoglobin of the Antarctic fishes Trematomus bernacchii and Trematomus newnesii: structural basis for the increased stability of the liganded tetramer relative to human hemoglobin - Biochemistry, 40, 3062-3068 (2001).

M. Gattoni, M.C. Piro, A. Boffi, W.S. Brinigar, C. Fronticelli, and E. Chiancone - The heme-globin and dimerization equilibria of recombinant human hemoglobins carrying site-specific b chain mutations – Arch. Biochem. Biophys. 386, 172-178 (2001).

R. Chiaraluce, V. Consalvi, S. Cavallo, A. Ilari, S. Stefanini, and E. Chiancone - The unusual dodecameric ferritin from Listeria innocua dissociates below pH 2.0 - Eur. J. Biochem. 267, 5733-5741 (2000).

X. Yang, E. Chiancone, S. Stefanini, A. Ilari, and N.D. Chasteen - Iron oxidation and hydrolysis reactions of a novel ferritin from Listeria innocua - Biochem. J. 349, 783-786 (2000).

E. Chiancone and A. Boffi - Structural and thermodynamic aspects of cooperativity in the homodimeric hemoglobin from Scapharca inaequivalvis - Biophys. Chem. 86, 173-178 (2000).

D. Verzili, C. Zamparelli, B. Mattei, A.A. Noegel, E. Chiancone - The sorcin-annexin VII calcium-dependent interaction requires the sorcin N-terminal domain – FEBS Lett., 471, 197-200 (2000).

A. Boffi, L. Guarrera, L. Giangiacomo, C. Spagnuolo and E. Chiancone - Proximal and distal effects on the coordination chemistry of ferric Scapharca homodimeric hemoglobin as revealed by heme pocket mutants - Biochemistry, 39, 33500-3504 (2000).

A. Ilari, S. Stefanini, E. Chiancone and D. Tsernoglou - The dodecameric ferritin from Listeria innocua contains a novel intersubunt iron-binding site - Nature Struct. Biology, 7, 38-43 (2000).

C. Zamparelli, A. Ilari, D. Verzili, L. Giangiacomo, G. Colotti, S. Pascarella and E. Chiancone - Structure-function relationships in sorcin, a member of the penta EF-hand family. Interaction with the ryanodine receptor and an Escherichia coli model system - Biochemistry, 39, 658-666 (2000).

T.K. Das, A. Boffi, E. Chiancone and D.L. Rousseau - Hydroxide rather than histidine is coordinated to the heme in five-coordinate ferric Scapharca inaequivalvis hemoglobin - J. Biol. Chem., 274, 2916-2919 (1999).

L. Guarrera, G. Colotti, E. Chiancone and A. Boffi - Ligand-linked changes at the subunit interfaces in Scapharca hemoglobins probed through the sulfhydryl infrared absorption - Biochemistry, 38, 10079-10083 (1999).

Ad Maiora

Michele Greco

RE: [OT] Scienza e Tecnologia - Cher - 29-09-2011 09:37

Mi associo alla segnalazione di M. Greco:

"Lunga vita" come in uso ad ogni augurio e brindisi al nuovo presidente dell'asociazione XL

http://www.ilgiornale.it/interni/sui_neu...comments=1

Combatto i parrucconi che ingessano la scienza

di Antonino Zichichi

Sulla velocità dei neutrini si sono fatte troppe chiacchiere. È per questo che vorrei rispondere alla compagnia di giro di filosofi, intellettuali e moralisti che sproloquia su giornali e televisioni. Risponderò con i fatti. Primo. Il Professore Zichichi, dicono, ha rotto il segreto che circondava lo studio sulla velocità dei neutrini? È questa l’accusa? Non ho affatto rotto il segreto. Prova ne è quello che ho detto mercoledì 21 settembre e pubblicato su Il Giornale il giorno dopo. Non una parola né sugli aspetti tecnici né sui famosi 60 nanosecondi. Era questo il segreto: 60 nanosecondi! Non le voci che c’era in ballo una grande scoperta. Questo lo sapevano tutti.

Nella mattina di mercoledì ho ricevuto telefonate di tre giornalisti italiani e due stranieri che, essendo io il padre del Gran Sasso e il primo fisico al mondo che abbia proposto lo studio dei neutrini prodotti al Cern e osservati al Gran Sasso (come ha fatto il gruppo «Opera»), mi ponevano domande sui risultati ottenuti. Domande alle quali non ho risposto. Dopo cinque telefonate ho chiamato Vittorio Macioce, un giornalista che stimo, dicendogli che correvano voci di una grande scoperta e che ci sarebbero stati al Cern e al Gran Sasso due seminari sulle proprietà dei neutrini. Il segreto da me rivelato sarebbe quindi l'annuncio di due seminari e il loro tema. Non vedo francamente dove sia lo scandalo.

Seconda chiacchiera. Attenzione, ricordano i parrucconi, la scoperta deve essere confermata. Risposta. Sono stato il primo a dire che l’esperimento necessita di conferma sperimentale. Se confermato sarà la più grande scoperta del secolo. Ho detto e ripetuto: se confermato. Ed ecco un fatto da me vissuto in prima persona. Negli anni sessanta arrivò dall’America la notizia di una grande scoperta: il primo esempio di particella «scalare» il che vuol dire tipo «pallina». Siccome tutte le particelle note erano tipo «trottolina» questa scoperta fu ai tempi una «bomba». Ripetendo l’esperimento al Cern dimostrai che la particella tipo «pallina» non esisteva. Ancora oggi nessuno ha mai scoperto una particella tipo pallina. Non ho quindi nulla da apprendere dai colleghi che pontificano senza avere mai fatto un esperimento. Tutti i fisici sanno che la verifica sperimentale è indispensabile.

Terza chiacchiera. Le scoperte debbono essere date al grande pubblico dopo che sono state pubblicate su una rivista scientifica. Risposta. Non ho nulla da imparare su quando una scoperta deve essere data al grande pubblico. Ecco qui un altro fatto. Quando scoprimmo al Cern il primo esempio di antimateria nucleare (correva l’anno 1965) ci limitammo a inviare la descrizione rigorosa dell’esperimento e i risultati ottenuti alla rivista scientifica più prestigiosa d’Europa. Dopo molte settimane l'esperimento venne ripetuto in America e i risultati dati subito alla stampa. Gli autori americani pretendevano di avere la priorità scientifica proprio per averla fatta conoscere a tutti prima della rivista altamente specializzata, che ha tempi lunghi in quanto un lavoro viene sottoposto a verifiche rigorose, prima di essere pubblicato. Però incominciò così il problema su cosa fare. Gli autori della scoperta sulla velocità dei neutrini che dal Cern arrivano al Gran Sasso hanno deciso di fare il Seminario al Cern nello stesso giorno in cui hanno stampato il preprint.

Coloro che pensano di avere il diritto a pontificare - pur non avendo mai scoperto niente - debbono rendersi conto che dal 1965 è passato quasi mezzo secolo. Oggi - non certo per colpa di Zichichi - tutte le scoperte vengono date al grande pubblico ben prima di essere stampate su riviste specializzate. Questo nulla toglie al rigore col quale si deve realizzare un esperimento e alla riproducibilità di una eventuale scoperta che da quell’esperimento può venir fuori. E con questo spero di aver risposto a chi mi tira in ballo, con lezioni sul galateo scientifico.

RE: [OT] Scienza e Tecnologia - lucaberta - 29-09-2011 12:08

Credo che questo articolo di Zichichi centri in maniera *perfetta* uno dei gravi problemi che affligge l'umanita' intera, ultimamente.

Mi riferisco al fatto che tutto deve essere chiaro fin da subito, ci devono essere immediatamente dati chiari e precisi per ogni evento o situazione, quando magari la natura stessa delle cose va contro il "tutto subito".

L'evento piu' lampante lo abbiamo avuto settimana scorsa con il rientro in atmosfera di UARS, quando la NASA e' stata indicata come ignorante o peggio complottista nel non saper dare informazioni piu' precise su di un evento che, per sua natura, ha un sacco di variabili in gioco. Ed un errore di qualche secondo sul calcolo del rientro voleva dire magari 1000km in piu' o in meno sul punto di effettivo rientro.

Per tacere poi degli incidenti aerei, dove tutto deve essere chiaro sin da subito, e se ci sono indagini che vanno avanti per mesi, e' perche Airbus o Boeing o la compagnia aerea stanno insabbiando le cose.

Non menziono piu' di tanto il nucleare. TEPCO e' stata massacrata in continuazione facendo di tutta l'erba un fascio. Ora che i reattori sono in cold shutdown con tre mesi di anticipo sulla roadmap, ovviamente nessuno spendera' una parola di complimenti nei confronti dei tanti tecnici che si sono ammazzati di lavoro per arrivare a questo evento di considerevole importanza.

Perche' il mondo ha cosi' tanta fretta? Dove stiamo andando cosi' in fretta?

Io sinceramente non ho una buona risposta. E voi?

Ciao, Luca

RE: [OT] Scienza e Tecnologia - Cher - 06-10-2011 21:43

http://www.youtube.com/watch?NR=1&v=1lpGqqyq530

E qui ci si diverte....................... mai vista un ammasso di fesserie tutte messe in unico "contenitore"!

mai vista un ammasso di fesserie tutte messe in unico "contenitore"!

Guardandolo con occhio attento e visto sotto l'aspetto di come si deve manipolare l'opinione di qualcuno , bè va prestata attenzione per carpine i meccanismi che utilizzano.

Capiti i meccanismi , il contenuto o l'argomento diventa irrilevante.

In pratica la scienza della comunicazione,come carpirne i meccanismi per proteggersi.

In fondo il nucleare è stato il primo "argomento" ipermanipolato per ceare la psicosi radiofobica nell'opinione pubblica.

RE: [OT] Scienza e Tecnologia - Cher - 20-11-2011 11:23

http://www.ilgiornale.it/interni/neutrin...comments=1

Neutrini più veloci della luce Primo ok dei super esperti

di Antonino Zichichi - 19 novembre 2011, 12:00

Il Gruppo OPERA ha dato la prima risposta alle numerose critiche su possibili «errori sistematici» in grado di invalidare la conclusione sulla velocità dei neutrini. Questa risposta riguarda la «partenza» dei neutrini, che è molto complessa.

Ha inizio al CERN con i protoni di alta energia che generano un fascio di «mesoni» i quali si trasformano in altre particelle tra cui i neutrini. Questa trasformazione avviene lungo un tunnel da un chilometro. Dal CERN parte quindi un «treno» di neutrini lungo ben mille metri.

A generare questo treno di neutrini sono - come detto prima - i protoni di alta energia, la cui struttura temporale è di fondamentale importanza. Nell'esperimento di OPERA la struttura in tempo dei protoni era di ben diecimila nanosecondi. Stava qui la prima difficoltà.

Siamo proprio sicuri che non ci siano errori «sistematici» nel passare dai diecimila nanosecondi di partenza ai sessanta nanosecondi nell'arrivo dei neutrini?

Era necessario partire con un fascio di protoni molto più stretto nel tempo. Partendo con un fascio di protoni - ciascuno di 3 nanosecondi - e distanti uno dall'altro 524 nanosecondi, il gruppo OPERA ha osservato al Gran Sasso 20 eventi di neutrini che riproducono la stessa struttura temporale dei protoni di partenza. I temuti effetti «sistematici» non ci sono. È così superata la prima difficoltà.

Come detto più volte su queste colonne quando la scoperta di OPERA sarà confermata da altri esperimenti avremo sul piatto delle certezze scientifiche la più grande scoperta degli ultimi 420 anni. L'avventura scientifica che ci ha portato agli orologi atomici e ai neutrini parte infatti con Galileo Galilei 420 anni fa, quando il padre della Scienza di primo livello cercò di capire cos'è la luce. A quei tempi nessuno sapeva alcunché sull'esistenza dei neutrini, le più leggere particelle dell'universo.

E si sapeva poco, quasi niente, della luce. Non se ne era capita la natura e tutti la pensavano dotata di velocità infinita. Tutti eccetto Galileo Galilei che pose la domanda: qualcuno ha misurato la velocità infinita della luce? Risposta: nessuno. Era quindi necessario misurarla. Le tecnologie di quei tempi erano le lanterne come sorgenti di luce e il ticchettio del polso come orologio.

Se la velocità della luce fosse stata trenta volte superiore alla velocità del suono, Galilei sarebbe riuscito a scoprire che la velocità della luce non era infinita. Purtroppo la luce viaggiava (e viaggia) a una velocità che è ottocentosettantamila volte superiore a quella del suono. Ecco perché l'esperimento non dette a Galilei il risultato sperato.

Oggi siamo agli orologi atomici e sappiamo misurare i tempi di volo delle particelle subnucleari con precisione da 15 picosecondi. È questo l'ultimo record ottenuto al CERN proprio in questi giorni. Un picosecondo è un millesimo di nanosecondo (miliardesimo di secondo). L'incertezza nella misura di OPERA è di 15 nanosecondi; se fosse di 15 picosecondi sarebbe mille volte meglio. A questo traguardo siamo arrivati partendo da Galilei che nel 1591 cercò di misurare la velocità della luce.

Partendo dal 1591, per capire cos'è la luce (una vibrazione del campo elettromagnetico), ci sono voluti trecentocinque anni con tante scoperte e invenzioni su cosa fanno le cariche elettriche e le calamite. La descrizione di queste scoperte richiederebbe centinaia e centinaia di pagine. La loro sintesi è in appena quattro righe: le quattro equazioni di Maxwell. Fu la più potente sintesi rigorosamente logica di tutte le scoperte in Elettricità, Magnetismo e Ottica.

Questa sintesi esigeva l'esistenza di una velocità assoluta: quella della luce che è di circa un miliardo di chilometri l'ora. Nella Conferenza Mondiale dei Fisici del 1896, trecentocinque anni dopo l'esperimento di Galilei, Lord Kelvin tenne la lezione d'apertura dicendo: «Cari colleghi, grazie alle quattro equazioni di Maxwell possiamo dire di avere finalmente capito cos'è la luce e che la sua velocità è una costante fondamentale della natura. Non può esistere alcun modo di trasmettere segnali a velocità superiori». Nasce così la comprensione rigorosa di tutti i fenomeni elettromagnetici cui si da il nome di Elettrodinamica Quantistica (QED: Quantum ElectroDynamics).

Chi scrive ha realizzato la prima rigorosa verifica di QED. Per far questo è stata necessaria l'invenzione di una nuova tecnica (oggi in uso in tutti i laboratori specializzati) per costruire campi magnetici polinomiali di altissima precisione. Senza QED non potrebbero esistere tutte quelle cose entrate nella vita di tutti i giorni: radio, TV, cellule fotoelettriche, telecomandi per aprire e chiudere le porte, telefonini, computer, Internet, tecnologie mediche (Raggi X, TAC, PET, Risonanza Magnetica, bisturi laser etc.) che hanno portato la speranza di vita oltre gli 80 anni ed elettrodomestici di ogni tipo; né alcun astronauta avrebbe potuto metter piede sulla Luna, se non avessimo scoperto QED: la logica delle Forze Elettromagnetiche che ha il suo baluardo nella velocità della luce, costante e assoluta.

Se è vero che i neutrini battono la luce in velocità, bisogna capirne le radici, che potrebbero essere numerose.

Le radici preferite da chi scrive sono nel Supermondo. In questo caso come la mettiamo con la tecnologia entrata nella vita di tutti i giorni? Niente paura, la nostra tecnologia non andrà in crisi in quanto ha radici in QED. Sono le estrapolazioni teoriche - incluse tutte le elucubrazioni filosofiche - che entreranno in crisi. Una cosa è certa: lo spazio-tempo con le 4 dimensioni (3 di spazio e una di tempo) non basta per descrivere ciò che abbiamo finora capito sulla Logica che regge l'universo.

Ci sono oggi almeno sette «motivi» che portano all'ipotesi del Supermondo, con le sue 43 dimensioni. Nessuno può prevedere i possibili sviluppi delle nostre ricerche intese a decifrare la Logica nella quale potrebbe entrare la velocità dei neutrini. Esattamente come nel 1896 né Kelvin né alcun altro fisico avrebbe saputo immaginare l'enorme quantità di scoperte scientifiche e di invenzioni tecnologiche occorse dal 1896 al 2011, grazie a QED. Una cosa è certa: se esiste il Supermondo si aprirà per tutti un orizzonte scientifico con 43 dimensioni di spazio-tempo.

*Autore del Progetto Gran Sasso e professore emerito di Fisica superiore nell'università di Bologna

RE: [OT] Scienza e Tecnologia - michele.greco@alice.it - 06-12-2011 16:53

Mi auguro che ciò che segue non vi sia sfuggito.

IGNITOR E LA DOMANDA MONDIALE DI ENERGIA

I paesi consumatori di energia possono essere divisi per fasce:

nella prima fascia troviamo i paesi di antica tradizione industriale i cui consumi, in assenza di crisi economiche, di norma crescono al ritmo del 2 – 2,5% annuo e quindi da qui al 2020 i loro consumi cresceranno all’incirca del 25%;

nella seconda fascia troviamo la Cina e L’India che, rappresentando il 40% della popolazione mondiale, costituiscono un caso a sé. Secondo una media ponderata l’ incremento dei loro consumi energetici da qui al 2020 si aggirerà attorno al 250%;

nella terza fascia troviamo quei paesi che attualmente hanno un consumo pro capite nettamente inferiore a quello dei paesi della prima fascia, ma da qui al 2020 i loro consumi cresceranno del 300% e rappresentano 1 miliardo di persone;

nella quarta fascia vi sono quei paesi il cui consumo energetico si prevede che cresca ma non in modo così impetuoso come nei paesi della terza fascia; questi paesi nel 2020 consumeranno intorno al 50 – 60% più di oggi.

Infine ci sono un miliardo di persone che attualmente non dispongono di energia elettrica.

Tirando le somme e limitandoci ai consumi di energia elettrica è prevedibile che la domanda globale nel 2020 sarà almeno dell’80% superiore a quella del 2011.

Se queste previsioni non saranno contraddette da eventi catastrofici, su scala mondiale ci troveremo di fronte a tre opzioni:

• produrre energia elettrica a costi doppi o tripli rispetto agli attuali e questo per l’Italia, paese importatore di materie prime energetiche, sarebbe drammatico,

• costruire nuovi impianti a fissione in quei paesi che non rifiutano l’opzione nucleare e da questi importare energia (come del resto noi italiani stiamo già facendo importando energia elettrica dalla Francia direttamente o attraverso la Svizzera),

• investire decisamente nella ricerca e nella sperimentazione.

Veniamo dunque ad Ignitor.

Il progetto ha l’obiettivo di conseguire entro il 2016 la ignizione del plasma, dimostrare cioè la praticabilità della fusione al fine di produrre energia elettrica. Questo non significa avere risolto i problemi tecnologici che dovranno essere affrontati per arrivare alla costruzione di un prototipo di generatore di energia elettrica e dunque oggi non è possibile prevedere quando questo prototipo sarà disponibile. Tanto meno è possibile immaginare quale possa essere il costo industriale di un generatore a fusione.

Ma intanto il tempo incombe; che fare in attesa del generatore a fusione?

Ancora Ignitor ci viene in soccorso e, senza entrare in spiegazioni tecniche, di seguito accenniamo come, prima ancora di generare energia elettrica da fusione, Ignitor può comunque dare un grosso contributo alla produzione di energia elettrica.

Le odierne centrali a fissione nucleare, come pure quelle di terza e quarta generazione, attualmente allo studio, producono scorie radioattive. Semplificando, queste scorie possono essere divise tra scorie potenzialmente riutilizzabili e scorie inutilizzabili il cui tempo di decadimento (tempo necessario perché non siano più radioattive) si calcola in migliaia di anni.

Ebbene Ignitor produce una grande quantità di neutroni, per così dire pieni di energia; indirizzando questi neutroni sulle scorie delle centrali a fissione si otterrebbero questi risultati: il tempo di decadimento delle scorie inutilizzabili si ridurrebbe a qualche decina di anni, mentre le altre scorie da potenzialmente riutilizzabili diventerebbero concretamente riutilizzabili.

Come potete comprendere risultati di questo genere sarebbero straordinari.

Non basta, i neutroni pieni di energia forniti da Ignitor possono fare di meglio.

Da molti anni si sta studiando la possibilità di costruire impianti a fissione nucleare utilizzando il Torio, che non presenta i rischi legati alle scorie radioattive degli attuali impianti a fissione che utilizzano quali combustibili l’Uranio o il Plutonio. Le scorie del Torio hanno infatti un tempo di decadimento molto rapido. Oltre a ciò le riserve mondiali di Torio sono molto maggiori di quelle dell’Uranio (anche l’Italia ha le sue brave riserve di Torio) e, a parità di massa, la quantità di energia prodotta dal Torio è molto maggiore di quella resa dalle centrali a fissione che conosciamo.

Infine una ipotetica centrale a Torio produrrebbe energia solo grazie a una “alimentazione” esterna e quindi non presenta il rischio di una reazione a catena incontrollata.

In conclusione una centrale a Torio offrirebbe enormi vantaggi rispetto al nucleare tradizionale, sia in termini di gestione delle scorie che in termini di sicurezza.

Il problema è che il Torio non ne vuol sapere di subire la fissione, ma ecco che arrivano gli energici neutroni di Ignitor ed anche il Torio può diventare fissile.

Come avrete apprezzato un grande progetto di ricerca come Ignitor regala vantaggi collaterali, concreti e produttivi già nel medio periodo.

Ecco perché la ricerca è importante.

Ecco perché un paese che fa poca ricerca perde colpi, non crea occupazione e meno che mai ne crea di qualificata.

dicembre 2011

g. patruno

Michele Greco

RE: [OT] Scienza e Tecnologia - Cher - 06-12-2011 17:14

Grazie all'utente Michele Greco di aver segnalato il progetto IGNITOR

qui per saperne di più:

http://www.ignitor.it/index.html

RE: [OT] Scienza e Tecnologia - drugo - 06-12-2011 23:44

Ecco perché la ricerca è importante.

Ecco perché un paese che fa poca ricerca perde colpi, non crea occupazione e meno che mai ne crea di qualificata.

dicembre 2011

g. patruno

Michele Greco

La ricerca è fondamentale. E' anche importante investire le (poche) risorse sui progetti più promettenti, per quanto riguarda la ricerca applicata (discorso a parte la ricerca di base, che secondo il mio modesto parere dovrebbe essere finanziata a prescindere dalle risorse, nei limiti del possibile ovviamente).

Quindi: a che serve Ignitor?

1) a dimostrare la fattibilità della fusione controllata? Ottimo, ma allora usciamo da ITER.

2) a dimostrare che il professor Coppi ha avuto un'idea migliore del resto del mondo (possibilissimo: non metto in dubbio la valenza scientifica del progetto). Spiacente, ma perchè dovremmo spenderci i nostri 4 soldi?

3) a produrre neutroni veloci? già lo fanno i reattori veloci (appunto), gli acceleratori di particelle ecc.

4) a convertire torio in U233? Esistono fior di progetti per farlo con reattori termici, è stato dimostrato sperimentalmente negli anni 60.

Il Torio non diventa fissile, per inciso.

Ricordo infine che:

per il punto 1) ci stanno per arrivare in USA con il confinamento inerziale,

(https://lasers.llnl.gov/) alla faccia di 40 anni di esperimenti con i Tokamak

2) i neutroni veloci attivano e rendono radioattivo tutto quello che gli sta intorno, altro che niente scorie nucleari.

Mi piange il cuore, ma dubito che vedremo mai dei reattori a fusione connessi ad una rete elettrica, nel senso di produttori netti di energia.

Felice di essere smentito su tutti questi punti, un assai desolato

Drugo

RE: [OT] Scienza e Tecnologia - Cher - 14-12-2011 11:20

http://www.ilgiornale.it/interni/scoprir...comments=1

L'ultima scoperta del Cern: ecco la particella di Dio

di Antonino Zichichi - 14 dicembre 2011, 09:00

La «Particella di Dio» ha due proprietà straordinarie: anzitutto essere una autentica «pallina», non dotata di moto intrinseco rotatorio come sono le «trottoline». Eppoi essere dotata di massa immaginaria.

Non come concetto filosofico astratto. Ma come componente effettiva di quella cosa individuata dal grande fisico francese Joseph-Louis Lagrange (1736-1813) e per questo detta Lagrangiana. In termini semplici la Lagrangiana è la densità di energia legata a un fenomeno fisico.

Il primo passo per affrontare un problema fisico è infatti riuscire a trovare qual è la densità di energia legata al problema che si vuole cercare di capire. Ed ecco come nasce l’importanza della «Particella di Dio». Essa permette di fare calcoli senza avere risultati divergenti. Vediamolo con un esempio.

Se facciamo un calcolo per sapere quanto possiamo spendere per i regali di Natale diamo per scontato che il risultato deve essere ragionevole: esempio 350 euro. Se venisse fuori un numero come 350mila euro, dovremmo cercare di capire dove abbiamo sbagliato. Se ripetendo il calcolo trovassimo un numero ancora più grande, addirittura infinito, dovremmo concludere che quel calcolo ha dentro un errore che ci porta a risultati divergenti. È ciò che accade quando nei calcoli dei fenomeni fisici fondamentali si introduce la massa.

Un bel piatto di spaghetti non potrebbe esistere se la sua massa fosse zero. Il Sole, la Luna, le montagne, gli oceani, l’aria che respiriamo, noi stessi, non potremmo esistere se non ci fosse la massa. Eppure quando si cerca di descrivere in modo rigoroso l’Universo nelle sue proprietà fondamentali ci si accorge che sarebbe molto meglio se la massa potesse essere eliminata dalla descrizione matematica dei fenomeni fisici.

Volendo insistere nel tenere la massa, vengono fuori calcoli con risultati infiniti cui si dà il nome di «divergenze»: un bel guaio in quanto serve a poco descrivere tutto ciò che esiste come se fosse privo di massa.

Tornando all’altra proprietà della «Particella di Dio» - essere pallina - ricordiamo che qualsiasi cosa è fatta di «trottoline», non di palline. Le trottoline per fare il mondo a noi familiare sono di appena tre tipi: protone, neutrone ed elettrone.

Il protone e il neutrone sono fatti ciascuno con tre trottoline fondamentali dette «quark». L’elettrone invece è esso stesso trottolina fondamentale. Non esiste alcun esempio di particella fondamentale che sia di tipo «pallina» con massa immaginaria.

Furono sei fisici (Englert, Brout, Higgs, Guralnik, Hagen, Kibble) ad avere l’idea di mettere nella Lagrangiana una «pallina» con massa immaginaria. E infatti per diversi decenni la particella ipotizzata dai sei fisici venne per semplicità definita «bosone di Higgs».

Poi «Particella di Dio», per due motivi. L’enorme difficoltà nel provarne l’esistenza e il miracolo che avrebbe dovuto produrre: dare la massa a tutto ciò che esiste senza produrre le catastrofi dette divergenze. Evitare le divergenze non è un dettaglio banale.

E infatti sono stati due grandi fisici, Gerardus ’t Hooft e Martinus Veltman, a dimostrare che l’introduzione di una pallina con massa immaginaria permette di superare i guai delle divergenze. Ecco quindi il grande miracolo: produrre la massa reale per tutte le «trottoline» fondamentali e cioè quark (necessari per fare protoni e neutroni) e leptoni (di cui l’elettrone è un esempio) che sono indispensabili per fare il mondo.

E produrre anche la massa zero per quella trottolina detta «fotone» di cui la luce è un esempio. Come se non bastasse la «Particella di Dio» con massa immaginaria genera una «Particella di Dio» con massa reale. È questa particella che da diversi anni noi abbiamo cercato di produrre nei nostri Laboratori al Cern, prima con la macchina Lep e oggi con la macchina Lhc.

Con la macchina Lep (il collisionatore di elettroni e antielettroni) siamo riusciti a stabilire che la «Particella di Dio» non poteva esistere con massa inferiore a 114 miliardi di elettronvolt; qualcosa come 120 volte la massa dei nostri protoni (chi scrive è stato co-autore del progetto per cercare il bosone di Higgs con Lep).

Con la nuova macchina del Cern (Lhc Large Hadron Collider operante a 7mila miliardi di elettronvolt) sembra che i primi segni della sua esistenza con massa superiore a quanto stabilito con Lep comincino a venir fuori. I due gruppi di ricerca (Cms e Atlas) hanno portato i risultati finora ottenuti ed è fuori discussione che le notizie sono incoraggianti.

Ieri al Cern, nell’Aula Magna strapiena di fisici, giornalisti e invitati d’eccezione, il responsabile supremo del Cern, Rolf Heuer, ha giustamente messo in evidenza il messaggio scientifico che nasce da queste nuove rigorose ricerche.

E cioè che c’è una sola certezza: entro il 2012 - prima dell’interruzione per venti mesi di Lhc - sapremo se la «Particella di Dio» esiste veramente o se toccherà a Lhc, operante a 14mila miliardi di elettronvolt, dare la risposta. È bene essere prudenti, essendo in gioco un problema la cui soluzione è attesa da circa mezzo secolo.

E infatti la prima volta che questo problema venne trattato fu alla Scuola internazionale di fisica subnucleare di Erice: correva l’anno 1964.

RE: [OT] Scienza e Tecnologia - Cher - 27-12-2011 12:37

http://www.ilgiornale.it/rubrica_cucu/cu...comments=1

Cura natalizia per egocentrici

di Marcello Veneziani - 23 dicembre 2011, 09:41

Per Natale vi regalo una cura formidabile contro il narcisismo e l’egocentrismo, malattie dilaganti.

Ho cenato a fianco al premio Nobel Carlo Rubbia e da lui ho appreso dati che azzerano ogni vanità legata all’ego.Dunque, il numero di cellule viventi oggi sulla terra dotate di dna individuale è di 5 seguito da trenta zeri.

Dunque, ciascuno di noi è solo un essere vivente tra 5.000.000.000.000.000.000.000.000.000. 000. Contenti?

Di esseri umani finora vissuti sulla terra ce ne sono stati appena 70 miliardi. Il dato allarmante è che il 10% è vivente. Una percentuale enorme, considerando la storia milionaria dell’umanità. Quando nacque Gesù sulla Terra ce n’erano in tutto 100 milioni. Oggi 70 volte di più e consumiamo tanto di più.

Per tenere alto il morale vi dirò che il numero totale di stelle, secondo Rubbia, è di 7 seguito da 23 zeri. Il sole, re del nostro piccolo universo, è solo un lumino di questi.

Per consolarmi, Rubbia ha detto che pur potendo girare a sinistra, tutti i dna conosciuti girano solo verso destra (dna sta per destra nazionale?). Ma io sono mancino.

Infine, l’universo sarebbe nato 13,4 miliardi d’anni fa e la terra solo 4 miliardi d’anni fa. Restano ignoti, diceva sconsolato Rubbia, i 9 miliardi e rotti di mezzo. Degli ultimi 4 miliardi d’anni sappiamo invece tutto... Avrei voluto obbiettare: e se gli zeri dei viventi fossero 31 anziché 30? Chi può dimostrare il contrario? E così il resto. Tutto mi pare così inattendibile e gratuito. Ma nel frattempo mi è sparito l’io,perduto nel cosmo. M’elimino d’immenso.

RE: [OT] Scienza e Tecnologia - Cher - 02-02-2012 21:43

http://www.loccidentale.it/node/113287

The winter is coming

Quelle sul riscaldamento globale erano solo "great balls of fire"

di Ronin 1 Febbraio 2012

Nel 2009, prima del Vertice di Copenaghen, un hacker pubblica informazioni riservate in un server russo: si tratta di uno scambio di email tra scienziati inglesi e americani che lavorano per l'IPCC (Intergovernmental Panel of Climate Change), l'ente delle Nazioni Unite che studia il cambiamento climatico.

I guru del "riscaldamento globale" vengono smascherati: dati opinabili, pressioni e ostracismo esercitati contro gli scienziati che non si piegano al pensiero unico, un atteggiamento che scredita gravemente l'immagine del panel e degli istituti collegati, tra cui la Climatic Research Unit della Università della East Anglia.

Nello stesso anno, una ricerca apparsa su Nature Geoscience evidenzia che il "global warming" non è legato solo alle emissioni inquinanti antropiche ma anche ad altri fattori, come la radianza solare e le maree degli oceani. Il Met Office's Hadley Centre respinge al mittente ogni dubbio spiegando che i modelli previsionali usati nelle ricerche sul clima tengono in considerazione la radianza e le maree, ma che la colpa del fenomeno è prevalentemente legata all'inquinamento terrestre (tesi sostenuta ancora oggi).

Ma la scorsa settimana, senza le fanfare mediatiche del passato, il Met e la Climatic Research Unit hanno fatto sapere che il Pianeta Terra NON si è riscaldato negli ultimi 15 anni, sulla base dei dati raccolti da 30.000 stazioni di rilevamento climatico.

Al contrario, rischiamo di avviarci verso una "mini ice age", un raffreddamento globale paragonabile (in difetto) a quello che nel 1648 provocò la gelata del Tamigi e dei canali di Amsterdam. Il futuro (prossimo) sarà più freddo. Ancora nel 2008, gli esperti del Met sostenevano che il periodo compreso tra il 2009 e il 2014 avrebbe raggiunto temperature calde da record.

Nonostante queste contraddizioni, i difensori del global warming continuano ad accreditarsi spiegando che il global warming è un fenomeno di lunghissimo periodo (l'inquinamento frutto del progresso umano in realtà non è poi così antico), e che cicli di raffreddamento nel contesto di un più generale riscaldamento del pianeta sono già stati registrati in passato. I ghiacciai himalayani però dovevano sciogliersi, mentre sono ancora al loro posto. Negli ultimi due anni la temperatura è scesa da 14,40 gradi celsius a 14,30.

Sul clima servirebbero più laicità e meno guerre di religione (la ritrita polemica fra pro-global warming e presunti "negazionisti"). I modelli di previsione sono semplici proiezioni, utili ma non un vangelo.

Per approcciarsi a tematiche del genere occorre al contrario una certa dose di incertezza, quel grado di "oscurità" senza la quale, secondo Thomas Kuhn, non si può comprendere la scienza.

Purtroppo il blocco che va dall'ICCP alle Nazioni Unite, da Al Gore al WWF, passando per l'Unione Europea (e i suoi fantasiosi obiettivi come il "20-20-20"), di dubbi non ne ha. Viene da chiedersi allora in base a quali interessi, che di scientifico hanno davvero poco, sia lecito legittimare ancora il paradigma scientifico vigente.

RE: [OT] Scienza e Tecnologia - Cher - 20-04-2012 11:26

http://www.ilgiornale.it/interni/la_font...comments=1

La fontana magica di Fermi che tiene "acceso" il sole

di Antonino Zichichi *- 20 aprile 2012, 10:58

Oggi alle 10, al Salone Conferenze del Viminale, c’è la cerimonia di inaugurazione del Museo storico della fisica e del Centro studi e ricerche «Enrico Fermi», di cui parte il restauro.

Il presidente Napolitano sarà al cortile del museo dove c’è la fontana del primo storico esperimento di Fermi. Antonino Zichichi* spiegherà l’importanza fondamentale di quella scoperta.

Perché il Sole non si spegne mai, né salta in aria? Chi garantisce l’estrema regolarità di questa sorgente di luce e calore così importante per la nostra esistenza? Se il Sole fosse più potente moriremmo di caldo. Se fosse meno potente, moriremmo di freddo. A garantire la quantità di luce e calore che il Sole ci regala è una Carica Fondamentale della Natura. Carica di cui nessuno aveva saputo immaginare l’esistenza, pur essendo dal suo valore che dipende la nostra vita.

A questa carica venne data da Fermi il nome di «carica debole» in quanto meno potente di quella elettrica; oggi essa è nota come «Carica di Fermi». Chi scrive ne misurò il valore negli anni sessanta del secolo scorso con un esperimento di alta precisione realizzato al CERN e dal quale scaturì la certezza che la Carica di Fermi aveva validità universale.

Quando osserviamo un cielo stellato dobbiamo ricordare che, nel corso di 10 mila anni di civiltà, nessuno aveva capito cos’erano le stelle. Per la plurimillenaria cultura cinese, le stelle erano «buchi» nell’infinito.

E nessun’altra civiltà era riuscita a capirne la natura.

La Carica di Fermi è la valvola di sicurezza che permette alle Stelle di brillare per miliardi di anni, emettendo più neutrini che luce. Mentre sto scrivendo questo articolo arrivano sul mio pollice, ogni secondo, 60 miliardi di neutrini emessi dal Sole. Fu Enrico Fermi a coniare il termine «neutrino» quando venne fuori che, studiando con rigore i fenomeni radioattivi, sembrava venisse violata la Legge di Conservazione dell’Energia.

Per evitare la violazione di questa Legge Fondamentale della Fisica era necessario che nel processo di radioattività venisse prodotta una particella leggerissima e priva di qualsiasi carica: il neutrino. La sua esistenza venne dimostrata sperimentalmente dopo vent’anni dalla ipotesi che dovesse esistere questa nuova particella. È grazie ai neutrini che il Sole si raffredda evitando di esplodere. Ed è grazie alla Carica di Fermi che la Stella a noi più vicina riceve la corretta quantità di combustibile per restare accesa nel corso di miliardi e miliardi di anni. In altre parole la Carica di Fermi agisce da valvola di sicurezza che garantisce la corretta quantità di combustibile alla Stella.

Il combustibile necessario al Sole sono però i neutroni. Nel Sole ci sono solo protoni ed elettroni, come in tutte le Stelle. Per produrre neutroni è necessaria l’esistenza di Forze che Fermi chiamò «deboli» in quanto molto meno potenti delle Forze Elettromagnetiche. Forze, che oggi vengono dette «Forze di Fermi». Grazie a queste Forze, quando nel Sole un protone si scontra con un elettrone, vengono fuori un neutrone e un neutrino. Il combustibile (neutroni) che alimenta il fuoco del Sole non potrebbe esistere senza le Forze di Fermi né potrebbero esistere i neutrini che evitano al Sole di esplodere.

Tutte queste idee hanno la loro sorgente nella vasca dei pesci rossi dell’Istituto di Fisica di Via Panisperna, dove Enrico Fermi ha fatto l’esperimento chiave che lo ha portato a scoprire le Forze oggi dette Forze di Fermi. Fu per questo che Fermi chiamò Fontana di nuove idee la vasca, oggi nota come Fontana di Fermi, sorgente delle Forze che venivano (e vengono) dopo quelle che ci fanno capire perché le pietre cadono sempre dall’alto verso il basso (Forze Gravitazionali) e dopo quelle che ci hanno fatto capire cos’è la luce (Forze Elettromagnetiche).

La Fontana di Fermi sarà una delle pagine più importanti nella storia della Scienza. È da questa Fontana di Fermi che è venuta fuori la soluzione del Mistero del Sole che secondo la Scienza di quei tempi avrebbe dovuto essere spento da tempo. E invece era acceso e perfettamente funzionante.

Facendo un salto di qualche migliaio di anni è certo che i nostri posteri verranno a Roma per vedere la Fontana che ha permesso all’umanità di sapere come mai può esistere un cielo stellato e come mai può esistere il fuoco che alimenta le Stelle. È questo fuoco che permette con un chilo di materiale «nuclearmente» combustibile di produrre la stessa energia che viene fuori dalla combustione di un milione di chili di materiale «elettromagneticamente» combustibile.

Il Sole per ben trecentocinquant’anni venne immaginato fosse una candela come quelle a noi familiari, quindi «elettromagneticamente» combustibile. La confusione tra i due tipi di fuoco portò al famoso «Mistero del Sole» nato con Galilei e Newton e durato fino alla metà del secolo scorso. Mistero la cui soluzione è venuta fuori grazie alla Fontana di Fermi.

* Presidente WFS (World Federation of Scientists), Beijing-Geneva-Moscow-New York

RE: [OT] Scienza e Tecnologia - Cher - 06-05-2012 12:50

http://www.loccidentale.it/node/115896

Che la scienza sia infallibile lo sanno anche molti scienziati (credenti)

Michele Marsonet 6 Maggio 2012

Partiamo dalla constatazione che non esiste “il” sapere dal quale tutti i tipi di conoscenza discendono, ma “tanti” saperi, la cui validità è ristretta a un ben determinato ambito del reale. Collocandoci da questo punto di vista, l’impossibilità di raggiungere il sapere definitivo dipende dai limiti - fisici e cognitivi - della natura umana. Dipende, cioè, dall’impossibilità per l’uomo di conseguire quello che nella filosofia contemporanea si definisce “il punto di vista dell’occhio di Dio”.

E’ opportuno notare a tale proposito come il positivismo, pur dopo il suo declino, continui a influenzare non solo numerosi esponenti del mondo filosofico e scientifico, ma anche la visione della scienza dell’uomo comune. Ancor oggi, infatti, è diffusa nel grande pubblico l’opinione che il sapere scientifico possieda un’assolutezza e una incontrovertibilità che lo rende immune da obiezioni, ragion per cui la scienza viene spesso considerata come l’unico paradigma cognitivo di cui disponiamo. Ne discende la concezione di un’umanità che, attraverso l’attività scientifica, diventa la dominatrice del reale poiché alla potenza del pensiero umano nulla può rimanere estraneo.

Si tratta di una concezione al contempo ingenua e arrogante. Il mondo che ci circonda, infatti, appare sempre più complesso e aperto, tanto nell’infinitamente grande quanto nell’infinitamente piccolo.

Ai nostri fini è interessante rilevare che molti scienziati notano che la visione della scienza come unico paradigma del sapere ha fatto il suo tempo. Da un lato la dimensione dell’osservabilità diretta non è più giudicata come tratto che sia in grado di tracciare confini netti tra scienza e metafisica. Capita così di leggere libri scritti da fisici in cui il concetto di “materia” viene considerato null’altro che un mito. Dall’altro si ritiene ormai superata la concezione newtoniana del mondo, con la sua visione dell’universo-macchina. Secondo Paul Davies e John Gribbin è significativo che la fisica - vale a dire la scienza-madre del materialismo - ne determini oggi la fine, in quanto la fisica del secolo passato ha fatto saltare i presupposti centrali della dottrina materialista.

Si può rilevare che, rifiutando la concezione scientista e meccanicista della metodologia scientifica, lo stesso Einstein definì “opportunista” il proprio programma epistemologico: “Lo scienziato apparirebbe perciò all’epistemologo sistematico come un tipo di opportunista privo di scrupoli: sembra un realista fintanto che cerca di descrivere il mondo indipendente dagli atti di percezione; sembra invece idealista, quando guarda a concetti e teorie come a libere invenzioni dello spirito umano, non logicamente derivabili dai dati empirici; sembra un positivista, quando riguarda i suoi propri concetti e teorie come quelli che si giustificano unicamente in quanto riescono a fornire una rappresentazione logica delle relazioni fra le esperienze sensoriali. Può persino dar l’impressione di essere platonico o pitagorico, nella misura in cui considera il punto di vista della semplicità logica come uno strumento indispensabile ed efficace della propria ricerca”.

La ragione di cui Einstein parla è intesa in termini assai vasti, un insieme complesso di cui fanno parte vari elementi tra loro legati e che si fecondano l’un l’altro. Si tratta di una ragione che, rammentando Pascal, può essere definita “ragione-cuore”, e che comprende scienza, arte, poesia, inconscio, etica, religione. Per indicare la complessità della propria epistemologia non positivista, Einstein ha usato la metafora dell’animale metafisico: “In breve, non tollero la separazione tra Realtà dell’Esperienza e Realtà dell’Essere. Ogni animale a due o a quattro zampe è de facto, in questo senso, metafisico”. D’altronde uno dei massimi storici della scienza del secolo scorso, Alexandre Koyré, ricordava che il pensiero scientifico non si sviluppa nel vuoto, ma è sempre collocato all’interno di un quadro di idee e di principi fondamentali che, abitualmente, si pensa appartengano alla filosofia in senso proprio.

Certo Einstein non proponeva di abbandonare la razionalità. Semplicemente vedeva che devono svolgere un ruolo importante altri elementi i quali, se usati in modo adeguato, possono supportare il pensiero scientifico. Ecco quindi la concezione delle teorie come libere invenzioni, l’esaltazione dell’intuizione e dell’immaginazione, il ruolo dello stupore che lo scienziato prova di fronte al mondo, l’accentuazione della funzione svolta dagli ideali etici ed estetici, il senso cosmico e religioso dell’universo e il primato della saggezza spirituale. Concetti e principi della fisica teorica sono dunque, secondo il più grande scienziato contemporaneo, creazioni libere dello spirito umano, suggeriti dall’esperienza, ma mai dedotti necessariamente da essa per astrazione. “Quel che vedo nella natura” - afferma lo stesso Einstein - “è una struttura magnifica che possiamo capire solo molto imperfettamente, il che non può non riempire di umiltà qualsiasi persona razionale”. Inoltre, “chi non è più in grado di provare né stupore né sorpresa è per così dire morto, i suoi occhi sono spenti. Non smettiamo mai di osservare come dei bambini incuriositi il grande mistero che ci circonda”.

Simili considerazioni dovrebbero indurci a riflettere anche sul carattere storico dell’impresa scientifica. La scienza è sempre il risultato dell’incontro tra il mondo naturale da un lato, e le concezioni e gli interessi pratici degli esseri umani dall’altro, vale a dire tra mondo e soggetto che vuole conoscere il mondo. John Dewey usava a tale proposito il termine “transazione” per denotare questo interscambio dove i contributi dell’osservatore e della realtà osservata non possono essere separati con una linea di confine rigida. Ogni volta che ci chiediamo quali siano le caratteristiche della realtà che possono essere scoperte, occorre sempre rammentare di aggiungere la domanda “scoperte da chi?”. Si può senz’altro sostenere che la natura presenti delle regolarità indipendenti dal soggetto che la indaga. Tuttavia l’evoluzione ci ha dotato di certe caratteristiche e non di altre, e ciò significa che siamo sensibili a certi parametri fisici e non ad altri. In altre parole, la scienza fornisce informazioni attendibili circa il mondo circostante, ma si tratta pur sempre di informazioni relative a una certa cornice concettuale che è la nostra.

Tutto questo induce, infine, a guardare con sospetto la tesi secondo cui scienza e religione sono schemi concettuali incompatibili. Alcuni si meravigliano per il fatto che molti scienziati famosi si dichiarano credenti, e i dibattiti dedicati al tema “scienza e fede” continuano ad essere popolari. La meraviglia cessa rammentando che l’assolutizzazione del sapere scientifico non è sostenibile. Se affermiamo che la scienza attuale ci fornisce la visione fedele di come il mondo è - spiegando quindi tutto - corriamo il rischio di ipostatizzare qualcosa che è soltanto un prodotto storicamente determinato. La sua validità è ristretta a un particolare periodo della nostra evoluzione culturale, e un approccio fallibilista dovrebbe impedirci di sostenere, anche alla luce dell’esperienza passata, che il quadro proposto dalla scienza dei nostri giorni possieda caratteri di assolutezza.

RE: [OT] Scienza e Tecnologia - Cher - 04-07-2012 10:59

http://www.ilgiornale.it/cronache/ecco_p...comments=1

"Ecco la particella di Dio" Annuncio al Cern di Ginevra

Raffaello Binelli - 04 luglio 2012, 10:32

Grande entusiasmo nel mondo della fisica per la scoperta la "particella di Dio", ossia il bosone di Higgs. Uno scienziato del Cern lo ha descritto così: "E' come un fiocco di neve".

Si era parlato della sua esistenza 48 anni fa, ma non c'era la prova. Ora è arrivata. I dati comunicati dagli scienziati indicano, con un margine di errore vicino allo zero, che il bosone di Higgs ha dimensioni comprese fra 125 e 126 miliardi di elettronvolt (GeV), ossia pesa fra 125 e 126 volte più di un protone, una delle particelle che costituiscono il nucleo di un atomo. Nel corso della conferenza stampa l’annuncio della scoperta ha suscitato un caloroso applauso tra i partecipanti, tra cui, in prima fila, l’83enne Peter Higgs, uno dei fisici che per primo aveva teorizzato l’esistenza della particella che a lui è stata dedicata

Perché è importante questa scoperta

L'esistenza della particella è determinante per spiegare le moderne teorie sull’universo. Ad averne rilevato l’esistenza sono stati i ricercatori che lavorano a due dei tre esperimenti che sono installati lungo i 27 chilometri di circonferenza del grande acceleratore di particelle di Ginevra, e cioè Atlas e Cms.

La ricercatrice italiana

Ci sono "forti indicazioni della presenza di una nuova particella attorno alla regione di massa di 126 GeV", ha spiegato a Ginevra Fabiola Gianotti, una delle oltre seicento ricercatrici italiane che hanno partecipato all’esperimento e coordinatrice di Atlas, uno dei due esperimenti che hanno scoperto il bosone.

Gaffe al Cern

Per un guasto tecnico a poche ore dall’annuncio più atteso della fisica contemporanea, sul sito del Cern è stato pubblicato un video in cui uno dei responsabili dei due esperimenti, l’americano Joseph Incandela, presenta i risultati sul bosone di Higgs. Il video, girato alcuni giorni fa, era stato archiviato su una rete interna al Cern e con accesso ristretto. Qualcuno ha modificato il titolo senza sapere che questa operazione avrebbe reso il video accessibile. Il problema è stato risolto rapidamente, ma nel frattempo il video era stato scaricato da un quotidiano britannico, che lo aveva pubblicato sul suo sito.

http://www.ilgiornale.it/video/il_bosone...piegazione

RE: [OT] Scienza e Tecnologia - Cher - 06-07-2012 12:43

5 Luglio 2012

Particella di Dio, ecco perché è così importante

Conoscerla significa arrivare all'essenza di tutto l'esistente

Il bosone di Higgs, con questo nome su cui si sono sprecati i giochi di parole, è stato l’argomento che ha spopolato ieri sui social network, #Higgs l’hashtag più diffuso su Twitter. Ma nel giorno del bosone devono essere stati in molti a chiedersi che cosa sia mai questa "particella di Dio", nome folkloristico ma assai più fortunato di bosone, e perché la sua (probabile) scoperta sia stata salutata con tanto entusiasmo. Proviamo a spiegarlo.

COSA SONO I BOSONI

I bosoni, innanzitutto. Chiamati così dal nome del fisico indiano Satyendra Bose, sono le particelle che, nel Modello Standard (la teoria più completa che ad oggi descrive come è fatto l’universo) trasportano una forza. L’altra classe di particelle sono i fermioni, costituenti della materia.

Il bosone di Higgs, la cui esistenza fu ipotizzata nel1964 dal fisico inglese Peter Higgs, che ieri ha assistito schivo e commosso al seminario al Cern di Ginevra, è speciale perché è la particella che conferisce la massa a tutte le altre, che le fa "esistere".

È in un certo senso la chiave di volta dell’intero Modello Standard. Per questo per i fisici era così importante osservarlo, cioè verificare sperimentalmente che esiste davvero, e che quindi la teoria ha un riscontro nella realtà.

L'IMPORTANZA

Finora, infatti, pur essendo stato il Modello Standard verificato in quasi tutte le sue parti con un altissimo grado di precisione, il bosone di Higgs mancava all’appello. E mancando la particella di Dio (in realtà leggenda vuole che prese questo nome per decisione dell’editore che modificò in "God particle" l’idea originale di titolo del libro del Nobel Leon Lederman: Goddamn particle, cioè «dannata particella») anche il resto della teoria era a rischio di crollo. Tutto da rifare e ripensare, insomma. Come se la fisica degli ultimi 50 anni si fosse "sbagliata".

GLI SCENARI APERTI

Non finisce però qui, e anche da questo deriva l’entusiasmo dei fisici. Ora si aprono nuovi scenari. Innanzitutto saranno da individuare le proprietà e le caratteristiche precise della particella osservata nei due esperimenti del Cern, Atlas e CMS. E i fisici dovranno stabilire se corrispondono proprio al bosone di Higgs previsto dalla teoria, o se ci sono delle anomalie, se la particella è più esotica di quello che ci si aspetta. Se così fosse, per esempio, il Modello Standard potrebbe comunque essere ancora messo in discussione, o ampliato, o superato. O potrebbero farsi largo altre teorie, come quella della supersimmetria, secondo cui ogni particella ha come partner una «superparticella», finora mai osservata da nessuno.

Autore: Chiara Palmerini

Fonte: http://scienza.panorama.it

RE: [OT] Scienza e Tecnologia - Cher - 06-08-2012 11:44

http://it.euronews.com/2012/08/06/la-son...e-di-vita/

La sonda Curiosity tocca Marte, in cerca di nuove forme di vita

Missione compiuta. Alla Nasa si festeggia, l’obbiettivo Marte è centrato.

Dopo un viaggio di 570 milioni di chilometri, la sonda Curiosity, planando col suo paracadute, ha toccato il pianeta: nel Centro Europa erano da poco passate, come previsto, le 7.30.

Il velivolo spaziale è grande all’incirca come un’auto e pesa una tonnellata.

Curiosity cercherà di rispondere alla domanda delle domande: esistono forme di vista extra-terrestri?

La missione, cominciata il 26 novembre scorso, è una delle più impegnative mai realizzate.

“L’arrivo nel cratere di Gale è assolutamente emozionante: un luogo in cui solo fino a pochi anni fa era inimmaginabile arrivare”, cosi’ aveva affermato, prima dell’arrivo di Curiosity, Doug McCuiston, capo della missione Nasa.

Il Mars Science Lab avrà due anni di tempo per andare a caccia di possibili tracce di vita tra i minerali presenti sul “pianeta rosso”.

-------------------------

per saperne di più

http://www.nasa.gov/multimedia/videogall...=149035461

RE: [OT] Scienza e Tecnologia - Cher - 10-08-2012 12:54

http://www.world-nuclear-news.org/

Happy sbarchi per il nucleare rover

6 agosto 2012

A propulsione nucleare rover è atterrato in sicurezza e con travi a vista di nuovo le sue prime immagini da Marte, dove si cercherà di rispondere a domande sul fatto che la vita sia mai esistito, né mai potrebbe esistere, sul pianeta rosso.

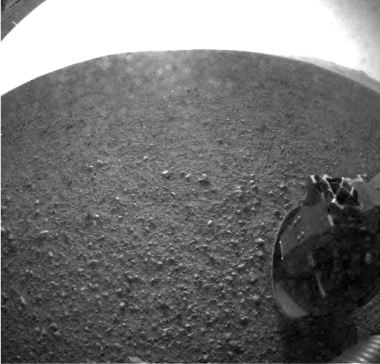

Un'immagine della superficie di Marte con travi a vista indietro di Curiosity (Foto: NASA)

Il più avanzato Mars rover ancora sviluppato dalla NASA, Curiosità , atterrato nel cratere Gale, dopo un volo di 36 settimane e il completamento dello sbarco più complesso mai tentato sul pianeta.

Apparecchiature scientifiche del rover comprende un laser-firing strumento per controllare la composizione elementare di rocce a distanza. Si userà un trapano e paletta alla fine del suo braccio robotico per raccogliere campioni di polvere del suolo e di interni di roccia, poi setaccio e dividere i campioni in strumenti di laboratorio di analisi all'interno del rover.

La curiosità è circa il doppio tempi lunghi e cinque pesante come NASA due rover precedenti Marte, Spirit e Opportunity , e il suo plutonio-powered batteria nucleare fornirà al laboratorio mobile con circa 2,7 kWh al giorno, di gran lunga superiore al kWh 1 al giorno massima dei precedenti energia solare rover.

La batteria nucleare è anche molto di più lunga durata rispetto ai sistemi di energia solare utilizzati dalle missioni precedenti, e si prevede che durerà attraverso operazioni programmate del rover e oltre, fornendo la possibilità per la missione di essere prorogato.

Il rover è attualmente previsto per trascorrere due anni a indagare se la regione mai ospitato condizioni che avrebbero potuto essere favorevole per la vita microbica. Osservazioni dall'orbita già identificato minerali argillosi e solfato nella zona, suggerendo una storia bagnato.

Amministratore della NASA Charles Bolden ha descritto l'atterraggio di un risultato straordinario e di un passo significativo verso l'obiettivo di inviare esseri umani su Marte a metà del 2030. "Oggi, le ruote di curiosità hanno cominciato a tracciare il sentiero per impronte umane su Marte ", ha detto.

L'Ufficio delle Nazioni Unite per gli Affari Spaziali (UNOOSA) riconosce che le fonti di energia nucleare sono "particolarmente adatti o addirittura essenziale" per alcune missioni spaziali esterne, grazie agli attributi ivi compresa la loro compattezza e durata nel tempo.

Ha adottato una serie di principi applicabili alle "fonti di energia nucleare nello spazio dedicato alla generazione di energia elettrica sul bordo di oggetti spaziali per scopi non-propulsivi", tra cui una serie di linee guida e criteri per il loro uso sicuro in missioni in cui non fonti di energia nucleare non è un'opzione ragionevole.

Ricercato e scritto

da News World Nuclear

RE: [OT] Scienza e Tecnologia - Cher - 21-08-2012 15:58

http://www.ilgiornale.it/news/cultura/la...30900.html

Demonizzare il nucleare? Non è scientifico

L'atomo non è il male. Piuttosto è il cyber-terrorismo a fare pauraIl convegno. Le vere emergenze planetarie

Matteo Sacchi - Mar, 21/08/2012 - 12:53

Erice - Q uando si parla di minaccia planetaria di norma le cose a cui si pensa sono quelle che ci raccontano i film o i giornali un po' apocalittici.

Ecco, giusto per citarne qualcuna: una grande asteroide che ci faccia fare una brutta fine come ai dinosauri, un cambio climatico provocato dal global warming, magari una guerra nucleare su vasta scala. Beh, quando si è finito di giocare con la fantasia, restano sul tappeto le questioni vere. È proprio di queste che si discuteva ieri alla fondazione Ettore Majorana di Erice negli «International seminars on planetary emergencies» voluti dal professor Antonino Zichichi e organizzati sotto il patronato del Presidente della Repubblica.

Il primo tema preso in esame è stato quello del terrorismo, un pericolo ben più rilevante dell'eventuale impatto di un asteroide. Ecco, anche sul terrorismo le cose non stanno esattamente come potremmo aspettarcele. Il rischio più immediato e di ampia portata? Secondo Hamadoun I. Touré, segretario generale dell'Unione internazionale delle telecomunicazioni (Itu), l'attività terroristica più pericolosa è quella delle cyber-guerre.

Spiega Hamadoun: «Nel mondo digitale, nel web, non esiste un concetto definito di grande potenza… Le tecnologie che consento un attacco hacker costano poco, conta il cervello». E non è che si tratti di una questione incruenta, ormai attraverso la rete informatica si può bloccare l'energia elettrica di un intero Paese o compromettere a colpi di virus la sua ricerca nucleare. E, off the records, più di qualcuno degli esperti sostiene che sia la strategia che Israele vuole utilizzare con l'Iran. E a proposito di energia nucleare e di sostanze radioattive, se ne è parlato molto in quella parte di seminario intitolata «Mitigation of terrorist acts».

La così detta bomba sporca (ovvero una bomba convenzionale che però esplodendo rilascia degli isotopi radioattivi sino a quel momento contenuti in un involucro protetto) è una delle preoccupazioni più grandi. Per fortuna un ordigno di questo tipo è molto meno devastante di quanto potremmo immaginare. Il professor Ramamurti Rajaraman, dell'università di Jawaharlal Nehru di New Delhi, lo ha spiegato chiaramente: «Il pericolo maggiore di un ordigno che rilasci radionuclidi è dato soprattutto dall'ondata di panico che potrebbe scatenare. Sarebbe molto più efficace il terrore che la sostanza in sé». Quindi se da un lato va portata avanti una educazione collettiva a valutare correttamente il rischio (e questo vale anche per il nucleare civile che è molto più sicuro di quanto la gente creda) resta il fatto che per costruire una bomba sporca non c'è bisogno di avere in mano delle barre di uranio o del materiale fissile militare.

Come spiegano sia il professor Frank N. von Hippel (Princeton) che il professor Friedrich Steinhausler (Università di Salisburgo) ci sono fonti radioattive reperibili quasi dovunque. Steinhaulser dati alla mano ci dice: «Ogni anno in Europa vanno perse tra le trenta e le cinquanta piccole fonti radiattive. In agricoltura, tra i materiali biomedici… non è difficile metterci le mani per un terrorista». Insomma c'è altro da fare, il grande asteroide può attendere…

RE: [OT] Scienza e Tecnologia - Cher - 22-08-2012 11:15

http://www.ilgiornale.it/news/cultura/ri...31166.html

Il riscaldamento globale? Una bufala (troppo) costosa

Per gli scienziati l'aumento delle temperature è sovrastimato e basato su calcoli dubbi. E le politiche contro il global warming comportano grandi spese per benefici minimi

Matteo Sacchi - Mer, 22/08/2012 - 08:55

Erice - Quando un fenomeno è complesso, niente di più facile che interpretarlo male. Ecco, tirando le somme (a rischio di semplificare) quanto è emerso in questi giorni rispetto al riscaldamento globale agli International «seminars on planetary emergencies» voluti dal professor Antonino Zichichi e organizzati, sotto il patronato del Presidente della Repubblica, alla fondazione Ettore Majorana di Erice.Il global warming, infatti, è stato esaminato da un nutrito gruppo di scienziati sotto un profilo affatto particolare, quello dei costi.

Sì, perché se non è detto che il riscaldamento del pianeta sia per forza un disastro per l'umanità (noi bipedi implumi siamo passati durante la nostra storia attraverso moltissimi mutamenti climatici), però sembra potersi trasformare facilmente in un disastro economico. Ecco che quindi a Erice la palla è stata passata agli economisti, per la precisione: Christopher Essex, matematica applicata all'Università dell'Ontario, Ross Mckitrick economista canadese, Michael Jefferson della London Business School e Bruce Stram esperto a stelle e strisce di Elementi del mercato. A fargli compagnia nella conferenza due politici britannici, lord Nigel Lawson, ex Cancelliere dello Scacchiere (leggesi Segretario al tesoro) di Sua Maestà e il Visconte Monckton of Brenchley, a lungo uno dei principali consulenti di Margaret Thatcher (che da anni combatte sul fronte del clima). Ed è stato proprio Christopher Walter Monckton a mettere con precisione il dito nella piaga. Da quando si è aperto il dibattito sull'effetto serra gli scienziati si dividono tra chi suggerisce di adattarsi al cambiamento del clima e chi sposando i modelli matematici che ipotizzavano situazioni molto estreme ha suggerito interventi consistenti per mitigare l'aumento delle temperature. Hanno vinto i secondi. Ecco i risultati, esposti da Mockton, a quasi quindici anni dal protocollo di Kyoto.Beh, innanzitutto il cambiamento climatico sin qui è stato molto più lento del previsto. Agli inizi degli anni Novanta si pensava che le temperature sarebbero salite, a livello globale, di un valore compreso tra gli 0,2 gradi e gli 0,5 gradi ogni dieci anni. Invece l'aumento è stato solo di 0,14 gradi. E non è detto che le scelte umane c'entrino. Ma soprattutto il costo per ridurre le emissioni, anche di poco, è altissimo. L'esempio portato da Monckton è quello della CO2 Tax imposta in Australia. Per abbattere le emissioni globali di CO2 dello 0,0006 entro il 2020 gli australiani spenderanno 130 miliardi di dollari. Se tutti nel mondo praticassero la scelta australiana il costo salirebbe a 541 miliardi di dollari. Insomma, il rapporto costi benefici secondo Monckton è folle, per usare parole sue: «Se questa fosse una polizza assicurativa nessuno vorrebbe sottoscriverla… adattarsi al mutamento climatico ha costi molto più bassi».Ovvio che il dibattito a quel punto si sia spostato sui numeri. E qui il contributo più interessante è stato probabilmente quello del «padrone di casa», il professor Antonino Zichichi: «Per capire gli spostamenti di un elettrone servono delle equazioni non lineari… Possibile che sul clima, che è complessissimo, circolino così tanti modelli predittivi approssimativi, basati su una matematica elementare, e li si consideri attendibili?». E ancora, parlando con Il Giornale: «Il motore meteorologico è in gran parte regolato dalla CO2 prodotta dalla natura, quella CO2 che nutre le piante ed evita che la terra sia un luogo gelido e inospitale, quella prodotta dagli esseri umani è una minima parte… Eppure molti scienziati dicono che è quella minima parte a produrre gravi fenomeni perturbativi. Ma ogni volta che chiedo loro di esporre dei modelli matematici adeguati che sostengano la teoria (e comunque oltre ai modelli servirebbero degli esperimenti) non sono in grado di farlo. Serve un gruppo di matematici che controlli i modelli esistenti e dia dei responsi di attendibilità, spostano miliardi di dollari… Magari deviandoli da emergenze vere».Tra l'altro molto spesso i teorici dell'ecologia che criticano l'eccessiva produzione di CO2 sono gli stessi che si oppongono a testa bassa al nucleare. Risultato? Spiegato abbastanza bene nell'incontro di ieri mattina che ha coinvolto molti esperti dell'atomo, tra cui Hans-Holger Rogner dell'Agenzia internazionale per l'energia atomica e lady Barbara Thomas Judge dell'Autorità per l'energia atomica della Gran Bretagna.

L'Occidente ha arrestato il suo sviluppo nucleare. Però nel mondo sono in costruzione più di sessanta centrali nucleari. Molte in Paesi del Terzo mondo, in cui i controlli e i pareri dell'Agenzia internazionale sono nulli. Insomma, chi paga il dazio ecologico lo paga caro e forse a vanvera, chi non lo paga super-produce ma rischia di far danno a tutti, e non con la CO2.

RE: [OT] Scienza e Tecnologia - Cher - 27-08-2012 13:23

http://www.ilgiornale.it/news/cronache/c...32611.html

Dalla crisi dell'acqua all'allarme terrorismo: ecco i rischi planetari

Si sono chiusi oggi i lavori della 45° edizione dei Seminari sulle Emergenze Planetarie. Ecco le conclusioni

Antonino Zichichi - Lun, 27/08/2012 - 12:44

Si sono chiusi oggi i lavori della 45ma edizione dei Seminari sulle Emergenze Planetarie. Ecco alcune conclusioni. Anzitutto il pericolo di guerra nel Medio Oriente che ha due focolai in Siria e nello scontro tra Israele e Iran.

In entrambi i casi, di scientifico c'è poco, per il semplice motivo che le tecnologie in gioco sono ben note e la Scienza ha poco da dire.

Quando negli anni ottanta c'era il rischio di Olocausto Nucleare nello scontro tra le due superpotenze (USA-URSS) le tecnologie belliche (scudo spaziale e bombe-H di alta precisone) avevano bisogno delle frontiere scientifiche di quei tempi. Ecco perché i Consiglieri scientifici di Gorbachev (Velikhov) e di Reagan (Teller) potevano avere un ruolo determinante. La Scienza nel Terzo Millennio non dovrebbe più occuparsi di guerre ma di Emergenze Planetarie; qui il problema centrale è quello di evitare che le finte emergenze vengano privilegiate a discapito di quelle vere, che sono ben 71.

La prima è quella dell'acqua le cui sorgenti continuano a diminuire e la cui distribuzione deve fare i conti con i numerosi pericoli di inquinamento "standard" e da "terrorismo". La comunità scientifica della WFS (World Federation of Scientists, Federazione mondiale degli scienziati) vuole che i provvedimenti necessari vengano presi prima che qualche grosso guaio accada. Non dopo. Con l'energia le problematiche sono totalmente diverse. Di sicuro c'è che sei miliardi di persone vorrebbero avere la stessa energia pro-capite che hanno il miliardo di privilegiati (tra cui ci siamo noi). Con l'energia i problemi della sua distribuzione riguardano sia i guai tecnologici "standard" sia quelli provocati dal "terrorismo". Passiamo a un'Emergenza piacevole.

La vita media è fuori discussione che toccherà fra poco i cento anni e che ne vanno studiate le conseguenze con rigore scientifico. L'analisi individuale del DNA permetterà di sapere quali "pillole" vanno evitate e anche quali "cibi". Questo darà un contributo enorme a pericoli di invecchiamento le cui cause non sono a livello genetico ma determinate dai numerosi errori fatti per "ignoranza". Ecco perché è stato costituito un gruppo di lavoro totalmente dedito allo studio di queste problematiche la cui soluzione porterà la nostra vita media a superare i cent'anni in tempi non eccessivamente lunghi. In tempi che potrebbero essere addirittura inferiori al decennio. L'unica difficoltà essendo, non di natura tecnico-scientifica, ma esclusivamente politico-culturale.

Un'altra novità è l'attenzione che deve essere portata a ciò che avviene nel nuovo spazio aperto alla nostra attività esistenziale. Spazio che non ha bisogno né di Terra, né di mare, né di aria, né di spazio fisico come quello che dette vita al famoso SDI (Space-Defense-Initiative) ai tempi dell'ultima fase della Guerra Fredda e nota come Guerre Spaziali. No. Non c'è bisogno di spazio fisico. È lo spazio dell'informazione dove è fortemente necessaria la sicurezza che tutto proceda per evitare guerre cibernetiche. È infatti fuori discussione che si può mettere in ginocchio un'intera Nazione senza usare né bombe né missili intercontinentali. Ma facendo letteralmente "impazzire" la logica elettronica nelle distribuzioni di acqua e d'energia.

La WFS è impegnata - come ha già fatto in passato - in questa battaglia di civiltà. Battaglia che ha trovato nel Presidente della Repubblica Ceca, Václav Klaus, nel nostro Presidente Giorgio Napolitano e in altri esponenti politici un forte sostegno. Le notizie che arrivano dalla Cina, dalla Russia e degli Stati Uniti sono di grande valore essendo proprio così che le conquiste della Scienza possono entrare nella vita di tutti i giorni. Noi scienziati infatti possiamo solo elaborare progetti; ma la loro realizzazione richiede volontà politica. Se le Emergenze Planetarie, nate nel cuore della Scienza, diventassero veramente argomento di scelta nella campagna elettorale del Presidente Obama, di questo non potremmo che essere estremamente felici. I risultati ottenuti dalla WFS con i suoi cento progetti-pilota realizzati in cinquanta Nazioni sono la fonte di certezza che la Scienza dà al potere politico. E cioè che le vere Emergenze Planetarie possono essere affrontate e risolte. Di questa fonte è testimone il Presidente della Repubblica Italiana che da molti anni segue con vivo interesse i nostri lavori e che ha dato alla comunità scientifica internazionale la prova di quanto sia urgente l'istituzione di un Centro di Studi e Ricerche per affrontare i problemi delle Emergenze Planetarie.

* Presidente WFS (World Federation of Scientists), Beijing-Geneva-Moscow-New York

RE: [OT] Scienza e Tecnologia - Cher - 26-11-2012 21:54

http://www.ilgiornale.it/news/cultura/qu...59500.html

Quando l'Italia voleva partire a razzo per conquistare lo spazio

Fascisti su Marte? No, veneziani su Marte. Insomma la Serenessima che non contenta di conquistare i mari si lancia alla scoperta del sistema solare

Matteo Sacchi - Lun, 26/11/2012 - 14:55

Fascisti su Marte? No, veneziani su Marte. Insomma la Serenessima che non contenta di conquistare i mari si lancia alla scoperta del sistema solare. Del resto non fu un caso se il grande astronomo Galileo soggiorno a lunga a Padova, sede dell’ateneo della città lagunare. Ovviamente è un gioco, un’ucronia un po’ bislacca.

Però davvero l’Italia nella storia della missilistica in generale, e dei voli spaziali, più in particolare, ha un ruolo decisamente più importante di quello che le si attribuisce di solito. Per rendersene conto basta dare un’occhiata a "Storia italiana dello spazio" di Giovanni Caprara (Bompiani, pagg. 488, euro 19). Come spiega bene il sottotitolo -"Visionari, scienziati e conquiste dal XIV secolo alla stazione spaziale" - il libro ricostruisce secoli e secoli di scienza missilistica made in Italy.

E se il primo razzo citato con chiarezza nelle cronache occidentali (il primato dell’invenzione va ai cinesi) è proprio frutto dell’ingegno dei veneziani, che nel 1379 per riuscire a riconquistare Chioggia lo spararono sul tetto di una torre occupata dalle forze veneziane e la incendiarono, va detto che come in molti altri campi il primato nel settore pirotecnico è stato della nostra penisola molto a lungo. Ancora all’inizio del settecento i pirotecnici più famosi d’Europa erano i quattro fratelli Ruggieri di Bologna (sebbene i tedeschi avessero già iniziato a dire la loro con la progettazione di razzi a più stadi). Poi come spesso accade quando si passa dalla maestria artigiana alla necessita di creare delle vere e proprie industrie gli italiani persero lentamente terreno. Ancora ai primi del novecento nel nostro Paese si contavano numerosi teorici e discreti matematici attenti a quelli che ormai stavano diventando i primordi della missilistica militare e aerospaziale. Però mancavano i mezzi e i fondi. Così mentre la sperimentazione tedesca che avrebbe portato alle V1 e alle V2 di Wernher Von Braun avanzava contando su capitali quasi illimitati, Gaetano Arturo Crocco e il figlio Luigi lavoravano in via Panisperna (sì proprio dove Fermi ha posto le basi del suo Nobel) alla prime camera di combustione per razzi a propellente liquido prodotta in Italia. Troppi rischi, qualche incidente ed un budget ridicolo. Così come l’ Associazione piemontese razzi capitanata da Alberto Fenoglio che fece volare un’areorazzo (con cui a momenti Fenoglio si ammazzò) e diversi prototipi di missili a più stadi. Ma in clima di autarchia la battaglia dei materiali era insostenibile, e poi arrivo la guerra...

Era destino che sulla luna ci andasse qualcun’altro. Eppure anche pensando ai viaggi spaziali veri e propri un tocco di italianità non manca. Quasi tutte le sonde a lunga distanza utilizzano per viaggiare più velocemente un procedimento noto come fionda gravitazionale. Ad averne l’intuizione Gaetano Arturo Crocco che presentò uno studio di rotta interplanetaria che sfruttava i campi gravitazionali di più pianeti, al congresso astronautico del 1956 a Roma. La Nasa infatti, che i mezzi li aveva, prese appunti e da allora chiama quel tipo di voli Crocco Mission. Insomma anche in salsa spaziale si può parafrasare quel triste epitaffio: mancarono i mezzi non il valore... o le idee.

RE: [OT] Scienza e Tecnologia - Cher - 25-04-2013 16:29

http://www.ilgiornale.it/news/interni/qu...11452.html

Quel «difetto» nel cosmo che ci ha salvato dall'annientamento

Ricercatori italiani scoprono un'asimmetria dell'universo che spiega perché la materia ha "vinto" sull'antimateria

Antonino Zichichi - Gio, 25/04/2013 - 13:03

Un antigelato di fragola sarebbe esattamente eguale al nostro gelato di fragola: stessa forma stesso sapore. Ad assaggiarlo però dovrebbe essere un nostro fratello cosmico fatto di antimateria.